機械学習技術がシミュレーション(CAE)の世界を変えると言われている。CAE技術者の中でも機械学習に興味のある人も多い。

その一節が、ある動画で見受けられたので紹介したい。

機械学習、特にディープラーニングでは国内で一番有名なのが松尾豊先生。

2019年12月に公開された松尾先生の講義映像では、物理モデルの限界と、機械学習がそれを超える予測精度をいずれ提供する、という示唆をしている。

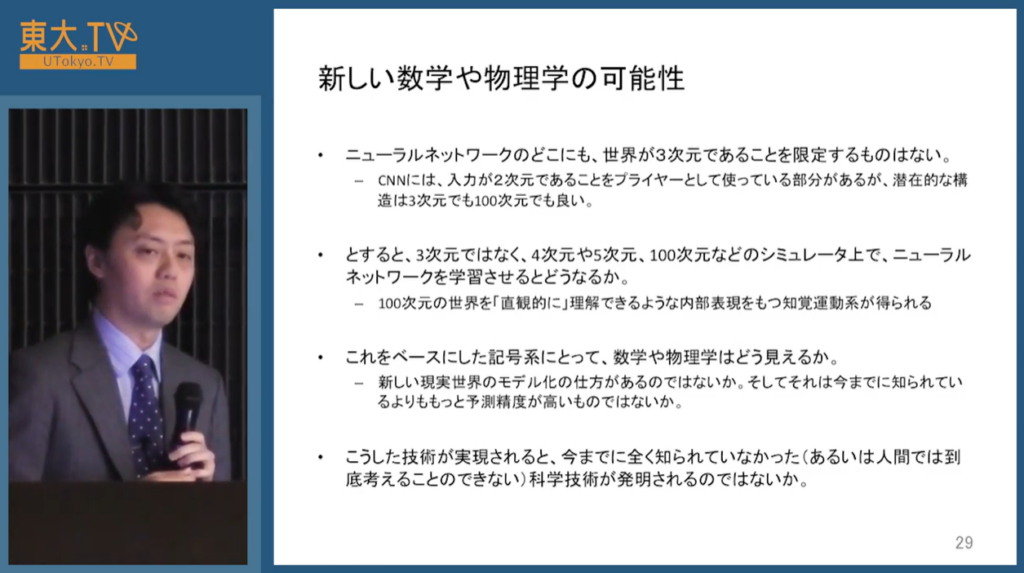

高次元のシミュレータ上で学習したモデルが、現実世界の新しいモデル化を可能にし、より予測精度があがる、とのこと。

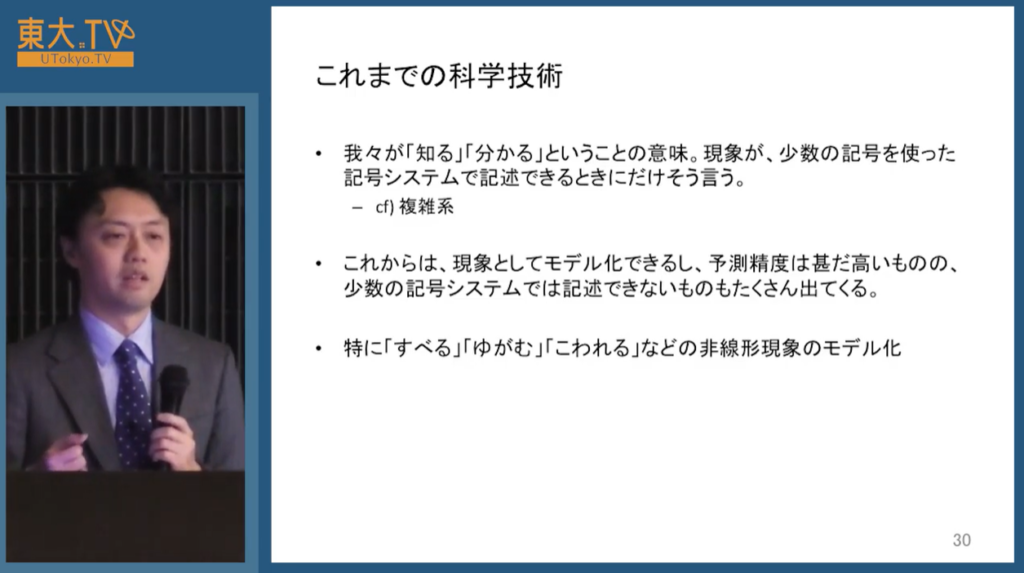

現在の物理モデルは、少数の要素に還元できるものが科学技術として発展してきた。今後は、中身の説明はできないが、非常に多くの要素で構成されたモデルが丸め込まれてでてくるのではないか、とのことだ。

確かに、破壊挙動や、非定常的な劣化現象、亀裂進展などは、CAEでもモデル化が非常に難しい分野。物理式に入れ込むべき要素が多すぎるのかもしれない。

そこを、機械学習で人間の頭で考えられないような次元で整理し、現象を予測する事が可能になるかもしれない。

これは、CAEのブレイクスルーというより、機械学習に取って代わられるという表現に近い。

CAEベンダーは大丈夫なのだろうか…

この講義では、CAEと関係なくても、他にも興味深い話がいくつかあった。

自然言語処理には、数年前まではRNN (Recurrent Neural Network)がよく使われていた。自分の認識もそうだった。

しかし、2017年6月に、GoogleがTransformerと呼ばれる技術を発表し、これが翻訳性能を大幅に改善させることが世に知らしめられた。

Transformerの応用がBERT(Bidirectional Encoder Representations from Transformers)であり、Kaggleコンペティションの自然言語処理問題において多用されている。

他にも衝撃的だったのは、Neural Ordinary Differential Equations(ODE)。

ニューラルネットの層が、1層2層ではなく、連続値の層数(1.5層や1.25層)を持つというものが出てきたらしい。もう意味がわからない。想像すらできない。

GQN(生成クエリネットワーク)という技術がDeepMindから発表された。場所の空間的な表現が得られ、任意の方向からの写真を想像できるというもの。興味深い。

このように、機械学習、特にディープラーニングは、今までの常識が完全に覆るような変化を、この数年で遂げている。注意深く調査を続けていかないと、時代に取り残されると感じた。

コメント